De kansen (en problemen) van AI

Nu de eerste successen en teleurstellingen rond artificial intelligence zichtbaar zijn, wordt het zaak om de impact van AI nader te onderzoeken. Wat betekent het voor de Nederlandse maatschappij? En hoe voorkomen we dat het gebruik van AI net zulke problemen veroorzaakt als social media? De Wetenschappelijke Raad voor het Regeringsbeleid kijkt inmiddels vooral naar de invloed van AI op wat men noemt ‘publieke waarden’, terwijl ECP een tool heeft gelanceerd om te voorkomen dat algoritmes op volstrekt oncontroleerbare wijze toegepast gaan worden.

Eerst de Artificial Intelligence Impact Assessment. Dit zegt het ECP|Platform voor de InformatieSamenleving daarover. “Door de roekeloze inzet van algoritmes, komt in de maatschappelijke discussie over artificial intelligence (AI) regelmatig de angst naar boven voor oncontroleerbare en volledig losgeslagen AI-algoritmes die hun eigen gang gaan. ECP|Platform voor de InformatieSamenleving roept op hoogoplopende discussies hierover te stoppen en te focussen op de slimme kansen die deze technologie biedt voor onze samenleving en economie. De medio november gelanceerde AI Impact Assessment is daarvoor de oplossing. Deze werd tijdens het Jaarcongres ECP overhandigd aan staatssecretaris van Economische Zaken en Klimaat, Mona Keijzer.”

Verantwoord toepassen

“Het debat rondom AI maakt emoties en ethische discussies los”, zegt Daniël Frijters van ECP|Platform voor de InformatieSamenleving. “Dat is gebruikelijk bij ICT-toepassingen, denk aan discussies rondom de slimme meter en de OV-chipkaart, maar bij AI lopen de gemoederen extra hoog op.” Dat heeft alles te maken met het zelflerend vermogen van slimme algoritmes. Zijn die nog te controleren of gaan zij ons overheersen? Beoordelen ze situaties vanuit menselijke ethische en juridische principes, of gaan ze hun eigen gang en leren ze zichzelf van alles aan?

De Artificial Intelligence Impact Assessment (AIIA) helpt bedrijven artificial intelligence verantwoord in te zetten, nu slimme algoritmes steeds vaker taken van mensen overnemen. Aan de hand van een stappenplan - dat bestaat uit acht stappen - maken bedrijven inzichtelijk welke juridische en ethische normen een rol spelen bij de ontwikkeling en inzet van AI-toepassingen, en welke afwegingen ten grondslag liggen aan keuzes en besluiten.

Praktijkvoorbeelden

“Neem een AI-selectietool voor het screenen van sollicitanten”, geeft Frijters als voorbeeld. “Het algoritme kan op basis van historische data leren welke kandidaten geschikt zijn voor een leiderschapsfunctie. Als niet wordt gekeken naar de betrouwbaarheid van de data, dan zullen vooral mannelijke kandidaten worden geselecteerd, omdat de selectietool op basis van de gebruikte historische data heeft geleerd dat vrouwen minder leiderschapsfuncties bekleden. Vrouwelijke kandidaten worden dus onbewust door het algoritme gediscrimineerd. Een van de stappen in de

AIIA is dan ook het controleren van de betrouwbaarheid van de databron.”

Een ander voorbeeld is het automatisch beoordelen of wetgeving op iemand van toepassing is. Dit kan misschien wel sneller en beter met een slim algoritme, maar een ambtenaar van vlees en bloed heeft de ruimte en de plicht om vanuit een fundamentele waarde als ‘menswaardigheid’ te handelen en individuele afwijkende situaties te beoordelen. In de AIIA worden dergelijke ethische en juridische vraagstukken getackeld, zodat het algoritme en de ambtenaar volgens menselijke waarden kunnen samenwerken.

In balans brengen

De AIIA wil rust en balans brengen in de discussie tussen wat ECP noemt ‘doemdenkers’ en ‘vooruitgang-gelovigen’. Dankzij dit stappenplan wegen bedrijven ethische, juridische en economische factoren tegen elkaar af. Op basis daarvan passen ze bijvoorbeeld hun algoritmen of toepassing van artificial intelligence aan, of zorgen ze ervoor dat mensen toch nog persoonlijk contact kunnen opnemen over geautomatiseerde besluiten. “Voorheen was AI-technologie nauwelijks transparant en ethische en juridische keuzes werden niet expliciet gemaakt”, aldus Frijters. “Daar krijg je allerlei wildwest- en spookverhalen van. De AIIA voorkomt dat. Burgers kunnen erop vertrouwen dat bedrijven die de AIIA uitvoeren, verantwoord omgaan met artificial intelligence en dat zij de gedragscode Artificial Intelligence volgen die onderdeel uitmaakt van de impact assessment.”

Overheidsbeleid

Tijdens een zogeheten Hollands Spoor-bijeenkomst ging een aantal door de Wetenschappelijke Raad voor het Regeringsbeleid uitgenodigde deskundigen met elkaar in debat over de vraag hoe AI de publieke waarden beïnvloedt. De sessie vormde de aftrap van een adviestraject van de WRR op het gebied van artificial intelligence. AI biedt volgens het kabinet veel kansen, maar er zijn ook uitdagingen. Die hebben veelal te maken met discriminatie, onwenselijke sturing van het gedrag van burgers en consumenten en de mate waarin AI-systemen gecontroleerd en gecorrigeerd kunnen worden.

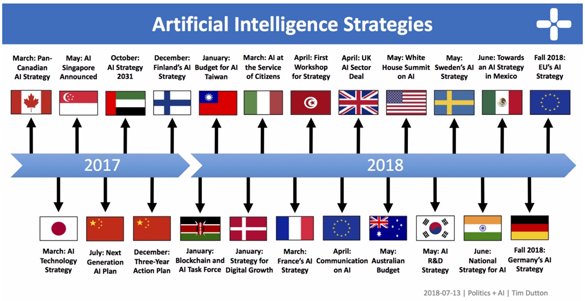

Nederland heeft tot op heden geen nationale AI-strategie, in tegenstelling tot een groeiend aantal andere landen, vertelde Bennie Mols tijdens de bijeenkomst. Hij is wetenschapsjournalist en auteur van het boek ‘Hallo Robot’. Welke prioriteiten stellen deze landen in hun strategieën? Welke impactgebieden keren daarin terug? Mols richtte in zijn lezing de aandacht op AI-overheidsbeleid en gaf daarbij een overzicht van enkele kenmerkende elementen in de door diverse landen inmiddels gepresenteerde AI-strategieën (zie figuur 1).

Centraal in deze strategieën staat het maximaliseren van de opbrengst van AI en het minimaliseren van de ermee gepaard gaande kosten en risico’s. China wil in 2030 wereldleider zijn in AI-innovaties en overheid en industrie werken daartoe nauw samen. Ook de VS ambiëren leiderschap en geven onder Trump ruimte aan de vrije markt voor innovatie. De EU komt eind 2018 met een strategie. Er ligt een mooie kans voor Europa om, in samenwerking tussen EU-landen, een middenweg te vinden tussen China (overheid-industrie) en de VS (vrije markt). Er ligt al een voorstel voor een groot gezamenlijk onderzoeksinstituut (Claire). Duitsland is van plan zich met AI op de industrie te richten. Het Verenigd Koninkrijk en Frankrijk hebben onderzoekscentra van grote tech-bedrijven aan zich weten te binden.

Discussie

Uit een verslag dat de WRR heeft gemaakt van de discussie tijdens de Hollands Spoor-bijeenkomst, komt naar voren dat het van groot belang is om de burger mee te krijgen bij de toepassing van AI. Hierbij moet het doel centraal staan en niet het middel: hoe breng je AI in de praktijk (AI als ‘capability’) op zo’n manier dat de techniek bruikbaar is? Hier ligt een taak voor de overheid. Verder gaat het erom dat de media de burger een gebalanceerde kijk bieden op AI: wat kan de technologie wel en wat niet? Ook verhalen van de werkvloer zijn essentieel om te vertellen, omdat ze de maatschappelijke impact van AI concreet maken.

De aanwezigen zien een belangrijke rol voor Europa weggelegd. De VS hechten groot belang aan de Europese markt: een grote markt met kapitaalkrachtige consumenten. Een markt waar de VS als belangrijke speler wil worden erkend. Dit biedt de overheid (EU) de kans om regels te stellen en af te dwingen dat bepaalde waarden worden geborgd. De kracht van Europa ligt op het gebied van juist die publieke waarden. Pak vraagstukken rond die waarden dan ook zoveel mogelijk internationaal op. Publieke waarden verschillen echter per land. Zorg daarom wel dat afspraken ook nationaal kunnen landen. Wel moet de EU zich realiseren dat ze de competitie verliest als de innovatie elders plaatsvindt. Overigens is een aantal bedrijven al volop bezig met AI. Gezamenlijk optreden van die bedrijven is van belang om verdere stappen te kunnen zetten. Voor start-ups geldt dat zij behoefte hebben aan een goede infrastructuur om op het gebied van AI iets te kunnen gaan betekenen.

Mens en machine

AI is volgens de deelnemers een containerbegrip, dat raakt aan data, algoritmes, presentatie en interactie, mensen en maatschappij. Al die aspecten verdienen de aandacht. De deelnemers beschouwen AI bovendien vooral als een hulpmiddel om slimmer, beter en productiever te worden. AI heeft echter ook beperkingen: bij ‘medical imaging’ scoort het systeem weliswaar beter dan de gemiddelde mens, maar het kan niet uitleggen waarom het tot zijn beslissing is gekomen. Daarom moet het bij AI altijd gaan om de combinatie van mens en machine: hybride AI. Die combinatie is overigens niet overal wenselijk. In de rechtspraak is een robotrechter bijvoorbeeld ondenkbaar. Een machine kan niet beslissen over partijen, onder andere vanwege het vertrouwen dat mensen moeten hebben in de rechtspraak. Dit laatste hangt samen met de empathie die een menselijke rechter kan uiten. AI creëert bovendien een dubbele trainingsbehoefte. Enerzijds zullen mensen met AI moeten leren werken. Anderzijds dreigt het gevaar dat nieuwe generaties niet langer in staat zijn om AI te beoordelen, omdat ze nooit zonder hebben gewerkt. Dit aspect verdient aandacht.

Publieke waarden

AI brengt ook vragen over bijvoorbeeld privacy en ethiek met zich mee. AI is bijvoorbeeld goed in personalisatie. Heb je dan het recht om niet-gepersonaliseerde informatie te ontvangen? AI geeft ook ruimte voor gedragsbeïnvloeding op een heel ander niveau dan tot nu toe. Wat doet dit met de balans in de samenleving? Dergelijke zaken behoeven transparantie. In meer algemene zin geldt dat controle nodig is op AI-activiteiten, bijvoorbeeld om vast te stellen hoe goed een algoritme moet zijn om te kunnen vertrouwen en vast te stellen of een algoritme wel de manier is om selecties te maken. Dit speelt als het gaat om de toewijzing van kinderen aan scholen (zoals in Amsterdam). Ook de rechtspraak krijgt meer en meer te maken met het beoordelen van besluiten die zijn gebaseerd op AI-applicaties. De vraag die daarbij speelt, is hoe de beslissing tot stand is gekomen. Wat zijn de gevaren als te snel op (slechte) algoritmes wordt vertrouwd? Ook kunnen fouten worden gemaakt bij het invoeren en verwerken van data. In het internationaal strafrecht speelt dit soort lastige kwesties bijvoorbeeld bij oorlogsmisdaden via geautomatiseerde wapensystemen: hoe zit het met de verantwoordelijkheid en de besluitvorming bij dergelijke systemen? Zijn de gebruikte systemen voldoende betrouwbaar? Moeten we zeggen dat AI niet in oorlogsvoering mag worden gebruikt?